Вымирание или бессмертие: революция искусственного интеллекта

Вымирание или бессмертие: революция искусственного интеллекта

Вот почему люди, осознающие проблему, называют искусственный сверхразум нашим последним изобретением — последней задачей, с которой мы столкнемся.

Добро пожаловать во вторую часть цикла «Как так получилось, что об этом не говорят на каждом шагу?».

Первая часть начиналась вполне безобидно: мы поговорили о слабом ИИ (такие системы специализируются на выполнении одной задачи: например, выбирают оптимальный маршрут или играют в шахматы) и выяснили, что он уже окружает нас повсюду. Ещё мы разобрались, почему так сложно сделать из слабого ИИ сильный (возможности таких систем во всех сферах либо сравнимы с возможностями человека, либо превосходят их), и почему в силу экспоненциального характера развития технологий сильный ИИ может появиться гораздо раньше, чем кажется. В конце первой части я напугал вас тем, что как только наши системы достигнут человеческого уровня, произойдет следующее:

Остается только уставиться в экран один на один с неуютной мыслью о том, что искусственный сверхразум (система, которая гораздо умнее человека во всех областях) могут разработать еще при нашей жизни, в попытке понять, какие эмоции по этому поводу испытывать.

В тему: Искусственный интеллект может вступить в конфликт с человеческой расой

Перед тем как углубиться в детали, давайте вспомним, что вообще считать искусственным сверхразумом.

Различают скоростной сверхразум и качественный сверхразум. В представлении многих людей сверхразумная система — это компьютер, который способен мыслить как человек, только в миллион раз быстрее. Там, где человек будет трудиться десять лет, система разберется за пять минут.

Впечатляет. Сверхразум и правда будет мыслить быстрее любого из нас, но по-настоящему отличаться от человеческого он будет по качеству, а это совсем другое. Люди намного умнее обезьян не потому, что быстрее соображают, а потому что мозг человека содержит ряд хитроумных когнитивных модулей, которые ответственны за сложные языковые представления явлений реального мира, долгосрочное планирование, абстрактное мышление, — а у обезьян их нет. Если разогнать мозг обезьяны в тысячу раз, умнее человека она не станет: ей и за десять лет не склеить из деталей замысловатую сборную модель — человек справится за пару часов. Человек наделен массой когнитивных умений, которые обезьяне не освоить, сколько бы времени она ни потратила.

Но дело не в том, что шимпанзе не умеют делать то, что умеем мы, — их мозг не в состоянии понять, что эти умения вообще существуют. Шимпанзе могут усвоить, что такое человек и что такое небоскреб. Но им никогда не понять, что небоскребы построили люди. В их понимании объекты такого размера — часть окружающего мира. Точка. Они не в силах не то что построить небоскреб, но и додуматься, что небоскреб вообще кому-то под силу построить. И все из-за небольшой разницы в качестве интеллекта.

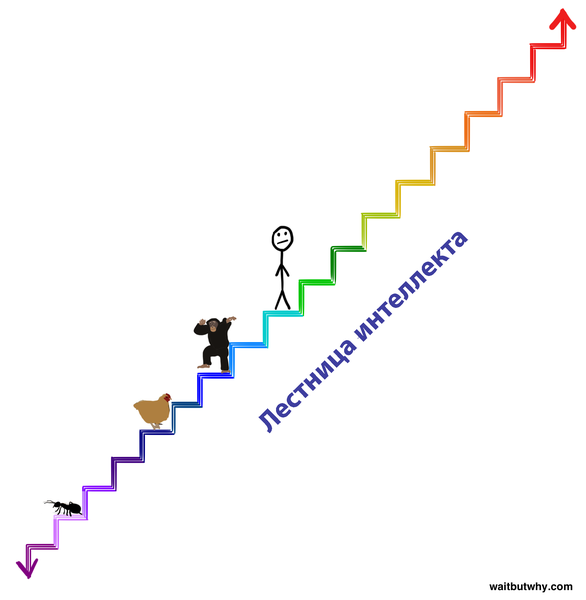

На фоне сверхразума, да и по меркам биологических существ, разница в качестве интеллекта человека и обезьяны крошечная. В одном из прошлых постов я изобразил диапазон когнитивных способностей живых организмов в виде лестницы:

Чтобы осознать всю серьезность появления искусственного сверхразума, поместите его на две ступеньки выше человечка на картинке. Это будет не самый мощный сверхразум, но по когнитивным способностям он будет превосходить нас так же, как и мы — обезьян. Шимпанзе недоступна мысль о рукотворности небоскребов, мы же не сможем понять, на что будет способна система на темно-зеленой ступеньке — даже если она попытается нам это объяснить. О том, чтобы это повторить, даже речи не идет. А разница всего в две ступеньки. Для системы за две ступеньки до конца лестницы мы — муравьи: она может годами учить нас простейшим (с ее точки зрения) вещам и не добиться успеха.

Возможности сверхразума, о котором мы поговорим сегодня, лежат далеко за пределами этой лестницы. При взрывном развитии интеллекта (чем умнее становится система, тем быстрее она совершенствует свой интеллект, пока тот не взмоет ввысь) системе могут понадобиться годы, чтобы превзойти в интеллекте шимпанзе, но всего пара часов, чтобы перепрыгнуть через нашу ступеньку и ступить на темно-зеленую. Через десять шагов от нас система будет преодолевать по четыре ступеньки в секунду. Поэтому необходимо уяснить следующее: вскоре после того, как выйдет сенсационная новость о создании первой системы ИИ человеческого уровня, мы с большой вероятностью будем сосуществовать на одной планете с объектом, который занимает на лестнице вот это место (а может быть, и в миллион раз выше):

А поскольку мы установили, что совершенно бесполезно пытаться понять возможности системы, которая всего на две ступеньки выше нас, давайте запомним раз и навсегда: узнать, как поведет себя искусственный сверхразум и чем это для нас обернется, невозможно. Любой, кто заявляет обратное, просто не понимает, что такое сверхразум.

Эволюция развивала биологический мозг медленно и постепенно сотни миллионов лет, и если люди создадут машину со сверхразумом, мы превзойдем эволюцию в плане скорости. А может, эволюция так и работает: уровень интеллекта ползет все выше, и достигнув некоторого уровня, изобретает искусственный сверхразум. Этот уровень ознаменует переломный момент, предвещающий новое будущее для всех живых существ.

По ряду причин, о которых мы поговорим позже, значительная часть научного сообщества считает, что вопрос не в том, доберемся ли мы до переломного момента. Вопрос в том, когда. С ума сойти.

Давайте оценим наше положение.

Думаю, никто в этом мире (уж точно не я) не сможет сказать, что случится, когда наступит переломный момент. Философ из Оксфорда, ведущий теоретик ИИ Ник Бостром считает, что все возможные исходы можно свести к двум большим категориям.

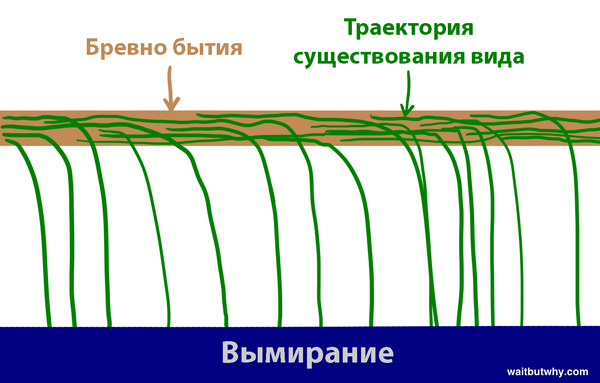

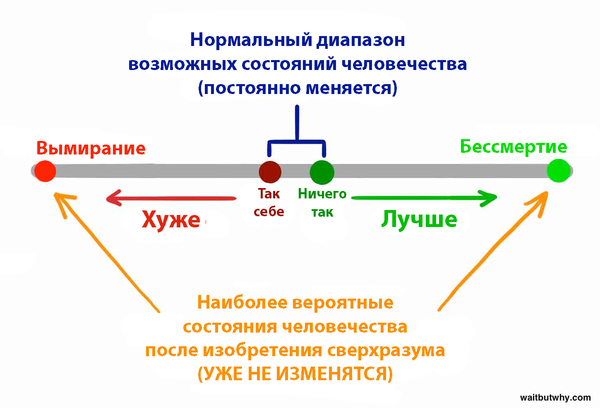

Во-первых, история показывает, что жизнь устроена следующим образом: биологический вид появляется на свет, некоторое время балансирует, как на гимнастическом бревне, но затем неизбежно падает — вымирает.

На протяжении истории правило «любой биологический вид однажды вымрет» подтверждалось не реже, чем правило «все люди смертны». К настоящему моменту на Бревне бытия не удержалось 99,9% видов. И совершенно очевидно, что если какой-то вид еще ковыляет по Бревну, его вот-вот столкнет какой-нибудь природный катаклизм или залетный астероид. Бостром называет вымирание точкой притяжения — все виды непременно туда упадут, вернутся же не дано никому.

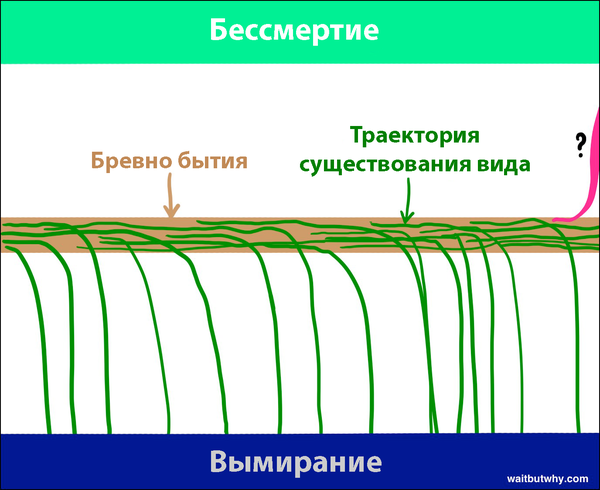

И хотя большинство ученых признает, что сверхразум будет в состоянии обречь людей на вымирание, многие верят, что есть шанс использовать его во благо и открыть для отдельных людей (и вида в целом) путь ко второй точке притяжения — видовому бессмертию. Бостром считает, что бессмертие (как точка притяжения) ничем не отличается от вымирания. Если мы до него доберемся, мы будем обречены на вечное существование: победим смертность и одержим верх над случаем. Таким образом, несмотря на то, что до сих пор с Бревна падали все без исключения виды, Бостром считает, что у Бревна два края, и просто не появился на Земле такой интеллект, который придумал бы, как падать в другую сторону.

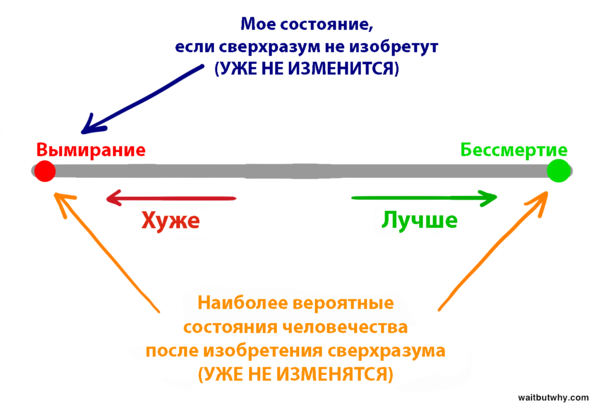

Если Бостром и другие теоретики правы (а судя по тому, что я читал, так и есть) нам нужно уяснить два факта, от которых захватывает дух:

1. Разработка искусственного сверхразума впервые в истории откроет возможность для одного из видов упасть с Бревна бытия в сторону бессмертия.

2. Разработка искусственного сверхразума станет для человечества доселе невиданным потрясением и с большой вероятностью столкнет человечество с Бревна либо в одну, либо в другую сторону.

Вполне возможно, что когда эволюция достигнет переломного момента, она разорвет связь людей с Бревном бытия и создаст один из двух миров: либо с людьми, либо без них.

Получается, для ныне живущих есть лишь два наиболее актуальных вопроса: «когда наступит переломный момент?» и «куда мы в этом случае упадем?».

Никто в мире не знает ответа ни на тот, ни на другой. Однако кое-кто из умнейших людей планеты десятилетиями пытался эти ответы найти. Оставшуюся часть статьи мы будем выяснять, к чему они пришли.

***

Начнем с первого вопроса: когда ждать переломного момента? Другими словами, сколько осталось времени до того, как первая система достигнет уровня сверхразума?

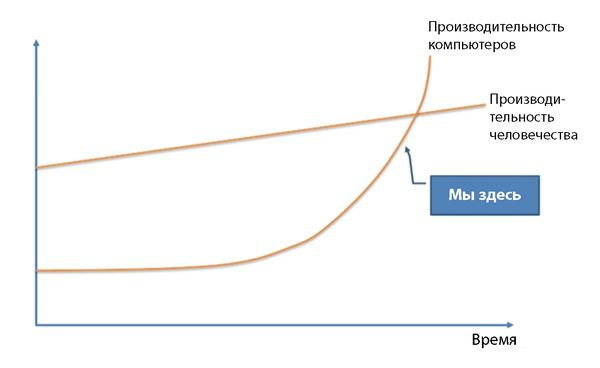

Вполне ожидаемо, мнения разнятся довольно сильно, среди ученых и теоретиков идет бурная дискуссия. Многие, в том числе профессор Вернор Виндж, ученый Бен Герцель, соучредитель Sun Microsystems Билл Джой, изобретатель и футуролог Рэй Курцвейл, согласились с экспертом в области машинного обучения Джереми Ховардом, который во время выступления на конференции TED представил следующий график:

Эти люди разделяют мнение, что сверхразум появится скоро: возможности ИИ растут экспоненциально. Сейчас алгоритмы машинного обучения только подбираются к нашему уровню, но уже лет через 30 оставят нас далеко позади.

А вот соучредитель Microsoft Пол Аллен, психолог-исследователь Гэри Маркус, специалист по информатике из Нью-Йоркского университета Эрнест Дэвис и технопредприниматель Митч Капор считают, что теоретики вроде Курцвейла серьезно недооценивают сложность задачи, и что переломный момент не так уж и близко.

Лагерь Курцвейла возражает, что если что-то и недооценивается, так это экспоненциальный характер роста. Сомневающихся сравнивают с теми, кто в 1985 году утверждал, что неспешно расцветающий интернет в ближайшем будущем никак не повлияет на нашу жизнь.

«Сомневающиеся» парируют: экспоненциальный характер развития интеллекта нивелируется за счет того, что сложность оборудования для его поддержания на каждом последующем шаге также будет расти экспоненциально. И так далее в том же духе.

Третий лагерь, куда входит Ник Бостром, не согласен ни с первыми, ни со вторыми, и считает, что: а) это абсолютно точно может произойти в ближайшем будущем; и б) никаких гарантий этому нет: возможно, потребуется больше времени.

Другие же, например, философ Хьюберт Дрейфус считают наивным полагать, что переломный момент вообще случится: скорее всего, до сверхразума мы никогда не доберемся.

Что получится, если сложить все эти мнения вместе?

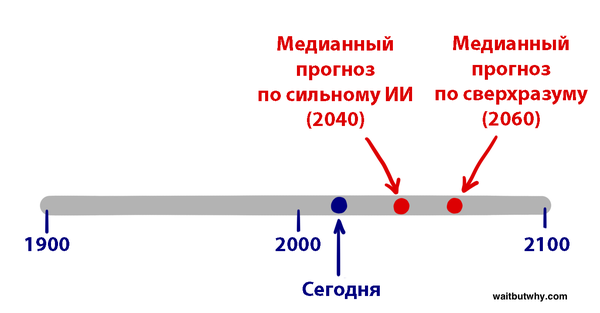

В 2013 году в ходе ряда конференций Ник Бостром и Винсент С. Мюллер задали нескольким сотням экспертов в сфере искусственного интеллекта следующий вопрос: «При условии, что научную деятельность человечества ничто серьезным образом не прервет, назовите год, когда с вероятностью P будет разработан ИИ человеческого уровня». Нужно было сделать три предположения: оптимистичное (сильный ИИ разработают с вероятностью 10%), реалистичное (с вероятностью 50%) и уверенное (с вероятностью 90%). Вот результаты:

Медиана оптимистического прогноза (P=10%): 2022 годМедиана реалистичного прогноза (P=50%): 2040 годМедиана пессимистичного прогноза (P=90%): 2075 годТаким образом, ученые склоняются к тому, что сильный ИИ, скорее всего, появится уже через 25 лет. Половина экспертов в области ИИ практически уверена, что сильный ИИ разработают в 2075 году. Это значит, что современные подростки его точно застанут.

На ежегодной конференции Бена Герцеля, посвященной сильному ИИ, Джеймс Баррат провел отдельное исследование. Он обошелся без оценки вероятности и просто просил респондентов ответить, когда разработают сильный ИИ. На выбор предлагались пять вариантов: к 2030 году, к 2050‑му, к 2100-му, еще позже или никогда. Вот результаты:

К 2030 году: 42% респондентовК 2050 году: 25%К 2100 году: 20%Еще позже: 10%Никогда: 2%Похоже на результаты Бострома и Мюллера. В опросе Баррата более двух третей опрошенных считают, что сильный ИИ появится к 2050 году, и менее половины считают, что это произойдет в ближайшие 15 лет. Также бросается в глаза то, что только 2% опрошенных в принципе не считают сильный ИИ частью нашего будущего.

Однако переломный момент случится не с разработкой сильного ИИ, а с разработкой искусственного сверхразума. Когда, по мнению специалистов, разработают его?

Мюллер и Бостром опросили экспертов, с какой вероятностью искусственный сверхразум разработают: а) через два года после разработки сильного ИИ (то есть взрывное развитие интеллекта произойдет почти мгновенно) или б) через 30 лет.

Для быстрого перехода от сильного ИИ к сверхразуму медиана оказалась в районе 10-процентной вероятности, для перехода через 30 лет или меньше — 75-процентной.

Из этих данных непонятно, о какой длительности перехода можно говорить с вероятностью 50%. На основе двух ответов выше давайте допустим, что на это уйдет 20 лет. Таким образом, научное сообщество в среднем считает, что переломный момент случится в 2060 году (cильный ИИ появится в 2040 году + понадобится еще 20 лет на переход к сверхразуму).

Конечно, все вышеперечисленные оценки носят спекулятивный характер и просто отражают мнение экспертов в сфере искусственного интеллекта. Однако это свидетельствует о том, что большинство сведущих людей сходятся во мнении: сверхразум, способный изменить жизнь на Земле, скорее всего, будет разработан к 2060 году. Всего через 45 лет.

Перейдем ко второму вопросу. Переломный момент наступил, куда мы упадем?

Сверхразум будет обладать колоссальной мощью, поэтому критически важно понять: кто или что будет эту мощь контролировать и с какой целью?

Ответ на этот вопрос определит, какое развитие получит искусственный сверхразум: станет он величайшим благом или смертоносным оружием.

Конечно, среди экспертов нет единого мнения, и вокруг этого вопроса споры также не утихают. В своем опросе Мюллер и Бостром просили участников оценить вероятность возможных последствий появления сильного ИИ, и выяснилось, что в среднем с вероятностью 52% все обернется хорошо или очень хорошо, и с вероятностью 31% — плохо или очень плохо. Относительно нейтральный исход возможен с вероятностью 17%. Иными словами, специалисты уверены в том, что появление сильного ИИ станет грандиозным событием. Также стоит отметить, что этот опрос касался появления сильного ИИ. Если бы речь шла о сверхразуме, вероятность нейтрального исхода была бы еще ниже.

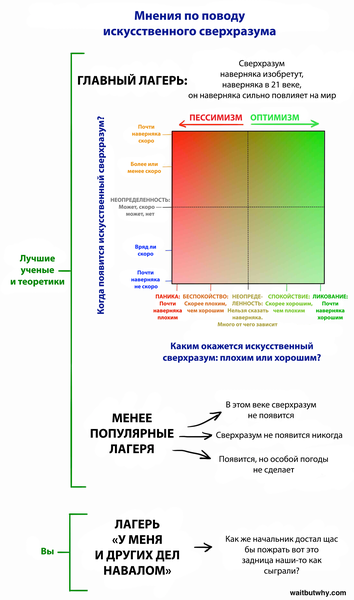

Прежде чем мы углубимся в рассуждения о плохом и хорошем исходах, давайте объединим ответы на оба вопроса в таблицу, которая охватывает взгляды большинства специалистов.

О главном лагере поговорим через мгновение, но сначала определитесь со своей позицией. Хотя... я и так знаю. До того как я начал изучать вопрос, у меня была такая же. Есть несколько причин, по которым люди вообще не думают на эту тему:

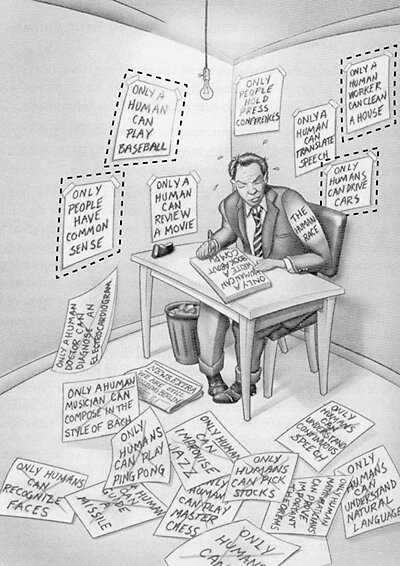

Как уже упоминалось в первой части, фильмы порядком всех запутали. Из-за нереалистичных сценариев с участием искусственного интеллекта мы вообще перестали воспринимать ИИ всерьез. По выражению Джеймса Баррата, это как если бы центры по контролю и профилактике заболеваний всерьез предупреждали бы о скорой эпидемии вампиризма.

В силу так называемых когнитивных искажений нам очень трудно поверить в реальность какого-то явления, пока мы не увидим доказательств. Уверен, в 1988 году специалисты регулярно обсуждали далеко идущие последствия развития интернета, но вряд ли кто-то считал, что это сильно повлияет на повседневную жизнь. Отчасти потому, что в 1988 году компьютеры много чего не умели. Люди смотрели на них и думали: «Серьезно? И эти штуки изменят мир?». Их воображение было ограничено тем, чему их научил личный опыт: они знали, что такое компьютер, и было сложно представить, на что компьютер станет способен в будущем. То же самое происходит сейчас с ИИ. Мы слышали, что разработка ИИ станет грандиозным событием, но поскольку мы пока не столкнулись с ним лицом к лицу, и в целом наблюдаем довольно слабые проявления ИИ в современном мире, нам довольно трудно поверить, что он кардинально изменит нашу жизнь. Именно против этих предубеждений выступают многочисленные эксперты, отчаянно пытаясь достучаться до нас сквозь повседневный шум поглощенности собой.

Даже если во все это поверить, проблема остается. Скажите, сколько раз за сегодня вы задумывались о том, что проведете остаток вечности в небытие? Немного, согласитесь. Хотя это гораздо важнее всего, чем вы обычно заняты. Все потому, что наш мозг чаще сосредоточен на повседневных мелочах, какие бы безумные перспективы ни сулило нам будущее. Так уж мы устроены.

Одна из целей настоящей статьи — вывести вас из лагеря под названием «У меня других дел навалом» и поместить в один из лагерей к экспертам (даже если вы стоите в месте пересечения двух пунктирных линий на квадрате выше, и не можете определиться).

В ходе исследования я натыкался на десятки разнообразных мнений по этой теме. Однако большинство из них составляют «главный лагерь», при этом три четверти приходятся на два лагеря поменьше в составе главного.

Мы тщательно изучим оба этих лагеря. Начнем с того, что повеселее…

Почему будущее может оказаться пределом наших мечтаний

По мере изучения мира ИИ я обнаружил, что на удивление много людей находятся вот в этом углу схемы:

Правый верхний угол гудит от предвкушения. Внимание здешних экспертов приковано к светлой стороне Бревна, и они уверены, что именно туда нам и дорога. По их мнению, в будущем нас ждет все, о чем только можно мечтать, — дай лишь срок.

От других теоретиков (о них чуть позже) их отличает не желание поскорее оказаться по счастливую сторону от Бревна, а уверенность, что именно туда мы и приземлимся.

Откуда эта уверенность берется — вопрос спорный. Критики считают, что предвкушение ослепляет: потенциальные негативные стороны замалчиваются или отрицаются. А сторонники говорят, что мрачные прогнозы всегда наивны: технологии как помогали, так и будут помогать нам больше, чем вредить.

Мы рассмотрим обе точки зрения, и вы сможете составить о ситуации собственное мнение. А пока умерьте скептицизм и давайте хорошенько разберемся, что нас ждет на счастливой стороне. Постарайтесь при этом принять тот факт, что все, изложенное ниже, может произойти на самом деле. Если показать охотникам-собирателям мир, где царят уют, технологии и бесконечное изобилие, он покажется им волшебной сказкой. Поэтому и нам нужно быть поскромнее и признать, что нас в будущем может ждать столь же непостижимая трансформация.

Ник Бостром описывает три роли, которые в будущем могут быть отведены искусственному сверхразуму:

«Оракул» точно отвечает на любой поставленный вопрос, в том числе сложный, на который людям не просто найти ответ («Как сделать более эффективный автомобильный двигатель?»). Google — примитивный тип «оракула».

«Джинн» выполняет любую высокоуровневую команду и переходит в режим ожидания («Возьми молекулярный ассемблер и создай новую, более эффективную конструкцию автомобильного двигателя).

«Монарх» получает более абстрактную цель и свободу действий. Каждый отдельный шаг он продумывает сам. («Изобрети личное средство передвижения, которое будет быстрее, дешевле и безопаснее, чем автомобиль»).

Людям эти вопросы и задачи кажутся сложными, но для сверхразума все будет выглядеть по-другому. Чтобы это прочувствовать, представьте, что вас просят разработать план по возвращению в работу упавшего карандаша. Справитесь? Поднимаем и кладем на стол.

Элиезер Юдковский (сам он на графике находится в «зоне тревоги») хорошо подметил:

Сложных проблем не существует — есть лишь проблемы, которые сложны для определенного уровня интеллекта. Даже небольшой шажок [в развитии интеллекта] переводит часть проблем из статуса «неразрешимых» в статус «очевидных». Чтобы очевидными стали они все, нужно шагнуть на нужное расстояние.

В «зоне комфорта» много увлеченных изобретателей, ученых и бизнесменов. Но на роль проводника в мир радужных представлений о будущем нам нужен лишь один.

Рэй Курцвейл вызывает двоякие ощущения. Некоторые боготворят его идеи, другие презирают. Третьи держатся посередине: Дуглас Хофштадтер красноречиво описал идеи Курцвейла как «кучу вкусной еды, которую перемешали с собачьими экскрементами, и теперь непонятно что где».

Как бы к его идеям ни относились, равнодушным они никого не оставляют. Он начал изобретать еще в подростковом возрасте, и в итоге стал автором ряда прорывных технологий: на его счету первый планшетный сканер, первый сканер, переводящий текст в речь, хорошо известный синтезатор Kurzweil (первое настоящее электропианино), а также первый коммерчески успешный распознаватель речи со словарем большого размера. Еще он автор пяти национальных бестселлеров.

Курцвейл известен своими смелыми прогнозами, многие из которых подтвердились. В конце 80-х, когда интернет был чем-то непонятным, он предположил, что к нулевым сеть станет явлением глобального масштаба. The Wall Street Journal назвал Курцвейла «беспокойным гением», Forbes — «совершенной мыслящей машиной», Inc. Magazine — «законным наследником Эдисона», Билл Гейтс — «непревзойденным предсказателем будущего ИИ». В 2012 году сооснователь Google Ларри Пейдж пригласил Курцвейла на пост технического директора. В 2011 году он стал соучредителем Университета Сингулярности, созданного под эгидой НАСА (частично его спонсирует Google).

Неплохо для одного человека.

С его биографией важно ознакомиться, потому что когда Курцвейл рассказывает о своем видении будущего, это похоже на бред сумасшедшего. Тем удивительнее узнать, что он далеко не безумец — он здравомыслящий, осведомленный и вообще не последний в мире человек. Можно считать, что он ошибается в прогнозах, но умалишенным его не назовешь. Я очень рад, что ему можно доверять, потому что, когда читаешь его прогнозы (многие из них разделяют и другие эксперты из «зоны комфорта»: например, Питер Диамандис, Бен Герцель), очень хочется, чтобы они сбылись. Попробуйте. Нетрудно понять, почему у него так много страстных поклонников (так называемых «сингуляритян»).

Вот что, по его мнению, произойдет.

Хронология

Курцвейл считает, что сильный ИИ разработают к 2029 году, а к 2045 у нас будет не просто искусственный сверхразум — возникнет совершенно новый мир. Именно это время он называет сингулярностью. Его хронология развития ИИ до сих пор считается возмутительно смелой, хотя за последние 15 лет быстрое развитие систем слабого ИИ заставило многих экспертов перейти на сторону Курцвейла. Его прогнозы по-прежнему более амбициозны, чем медианный результат в опросе Бострома (сильный ИИ получим к 2040-му, сверхразум — к 2060-му), но не намного.

По Курцвейлу, к сингулярности в 2045 году приведут три одновременных революции в сферах биотехнологий, нанотехнологий и, прежде всего, ИИ.

Нанотехнологии постоянно всплывают в материалах, посвященных искусственному интеллекту. Поэтому, перед тем как продолжить, давайте уделим минутку им…

Несколько слов о нанотехнологиях

Нанотехнологиями называют технологии, которые предполагают работу с материей размерами от 1 до 100 нанометров. Нанометр (нм) — это одна миллиардная метра или миллионная часть миллиметра. В диапазон от 1 до 100 нм входят вирусы (100 нм в диаметре), ДНК (10 нм в ширину), крупные молекулы (гемоглобин, 5 нм), и молекулы средних размеров (глюкоза, 1 нм). Если/когда нанотехнологии станут нам подвластны, следующий шаг — работа с отдельными атомами, которые меньше всего на один порядок (~0,1 нм).

Чтобы понять, в чем сложность работы с материей такого размера, давайте представим то же самое в больших масштабах. Международная космическая станция находится на расстоянии 431 км от Земли. Если бы люди были великанами и головой задевали МКС, они были бы в 250 000 раз больше, чем сейчас. Если увеличить диапазон от 1 до 100 нм в 250 000 раз, получим диапазон от 0,25 мм до 2,5 см. Нанотехнологии позволят этим великанам собирать сложные объекты из материалов, размеры которых варьируют от диаметра песчинки до диаметра глазного яблока. На уровне работы с отдельными атомами великану придется аккуратно располагать в пространстве объекты размером в 1/40 миллиметра: их можно разглядеть только в микроскоп.

Впервые о нанотехнологиях заговорил Ричард Фейнман. На лекции в 1959 году он сказал: «Известные нам принципы физики не запрещают создавать объекты «атом за атомом»... физики, в принципе, действительно могут научиться синтезировать любое вещество, исходя из записанной химической формулы. Химики будут заказывать синтез, а физики — просто «укладывать» атомы в предлагаемом порядке». Проще простого. Если разобраться, как передвигать отдельные молекулы или атомы, станет возможно абсолютно все.

Нанотехнологии стали серьезным полем для исследования в 1986 году: инженер Эрик Дрекслер представил их основы в своей главной книге «Машины создания». Однако сам Дрекслер считает, что те, кто хочет узнать больше о современных идеях в нанотехнологиях, должны прочитать его книгу 2013 года «Полное изобилие» (Radical Abundance).

Несколько слов о «серой слизи»

Как вам одна врезка внутри другой? Почему бы и нет.

А попали мы сюда потому, что говоря о нанотехнологиях нельзя не затронуть еще одну не самую приятную тему. В ранних версиях теории нанотехнологий был предложен метод наносборки — создания триллионов крошечных нанороботов, которые будут скоординированно что-то создавать. Произвести триллионы нанороботов можно, например, так: создать одного, который сможет делать собственные копии. Из одного такого робота получится два, из двух — четыре, из четырех — восемь. Несколько триллионов наберется уже за день. Такова сила экспоненциального роста. Умно придумано.

Так кажется ровно до тех пор, пока этот процесс случайно не приведет к полному и окончательному апокалипсису. Проблема в том, что сила экспоненциального роста предоставляет удобный способ быстрого создания триллиона наноботов, но при этом делает саморепликацию не самой приятной перспективой. Что если в системе произойдет сбой, и вместо того, чтобы остановить репликацию на паре триллионов, наноботы продолжат плодиться? Для поддержания процесса репликации наноботам нужно будет поглощать любой углеродсодержащий материал, а вся жизнь на Земле как раз из углерода и состоит. В биомассе Земли 10^45 (10 в 45-й степени) атомов углерода. В наноботе будет порядка 10^6 атомов углерода, поэтому 10^39 наноботов сожрут всю жизнь на Земле, и это случится всего за 130 репликаций (2^130 это чуть больше 10^39). Планету наводнит океан наноботов (та самая «серая слизь»). Ученые думают, что наноботы смогут реплицироваться за 100 секунд, а это значит, что простая ошибка может убить всю жизнь на Земле всего за три с половиной часа.

Может быть и хуже: если до нанотехнологий доберутся террористы и сумеют их перепрограммировать, они смогут создать несколько триллионов наноботов и дать им команду тихо и равномерно разлететься по миру за пару недель. Затем, по одному нажатию кнопки они съедят всю планету всего за полтора часа. Ввиду их равномерного распределения по планете остановить их будет невозможно.

Этот вариант развития событий широко обсуждался в течение многих лет, но хорошая новость в том, что это всего лишь страшилка. Вот что написал мне по этому поводу автор термина «серая слизь» Эрик Дрекслер: «Люди любят страшилки, и эта входит в один ряд с сюжетами про зомби. Только в этом случае мозги пожирает сама идея».

С помощью нанотехнологий мы сможем производить технические устройства, одежду, продукты питания, разнообразные биоматериалы: искусственные клетки крови, истребителей вирусов и раковых клеток, мышечную ткань — да все что угодно. В мире нанотехнологий стоимость материала не будет зависеть ни от того, насколько он часто встречается, ни от сложности производственного процесса — только от его атомной структуры. Производство алмазов может стать дешевле, чем производство ластиков для карандашей.

В этот мир мы еще не попали. Возможно, мы недооцениваем связанные с этим сложности, возможно, — переоцениваем. Но осталось не так уж и долго. По прогнозам Курцвейла, это произойдет к 2020 году. Понимая, что нанотехнологии могут изменить жизнь на планете, правительства государств вкладывают в их изучение миллиарды долларов (США, ЕС и Япония уже инвестировали в общей сложности порядка $5 млрд).

Только представьте, что сверхразум получит доступ к полноценному наносборщику. А ведь их придумал человек, и даже еще не приручил. А поскольку для искусственного интеллекта наши разработки — детский лепет, приходится предположить, что он сможет изобрести гораздо более мощные технологии, которые людям познать будет не под силу. Поэтому при ответе на вопрос «Чем обернется для нас революция ИИ?» невозможно переоценить масштабы грядущего. Даже если последующие прогнозы касательно сверхразума покажутся вам преувеличенными, помните: они могут воплотиться в жизнь способами, какие мы и представить себе не можем. Скорее всего, предсказать что-то подобное наши мозги тоже не в состоянии.

Чем ИИ может нам пригодиться?

За счет нечеловеческих способностей и всех технологий, до которых сверхразум сможет додуматься, он наверняка сумеет решить все проблемы человечества. Глобальное потепление? Сверхразум сначала прекратит выбросы углекислого газа, придумав эффективные способы добычи энергии без ископаемого топлива. Затем он придумает эффективный инновационный способ удаления избытка CO2 из атмосферы. Рак и другие заболевания? Не проблема — здравоохранение и медицина изменятся так, что невозможно представить. Мировой голод? С помощью нанотехнологий сверхразум будет создавать мясо, до молекулы идентичное натуральному (иными словами, настоящее мясо).

Нанотехнологии смогут превратить груду мусора в цистерну свежего мяса или другой еды (необязательно даже в привычной форме: представьте гигантский яблочный куб) и распределить все это по миру с помощью высокоэффективных логистических систем. Конечно, от этого выиграют животные — им больше не придется умирать ради нашего пропитания. Сверхразум сможет много чего сделать и для сохранения вымирающих видов, или даже возрождения уже вымерших по сохранившейся ДНК. Он сможет решить наши самые сложные макроэкономические проблемы: разрешить споры об экономической политике, мировой торговле, вопросы этики и философии — всё это будет для него элементарно.

Но больше всего манит другая потенциальная возможность сверхразума. Узнав об этом, я уже по-другому смотрю на все, что знал раньше.

Сверхразум поможет нам победить смерть.

Пару месяцев назад я рассказывал о том, как завидую более развитым цивилизациям будущего, которым удалось преодолеть собственную смертность. Я тогда и не думал, что в скором времени напишу пост, который и в самом деле вселит надежду на то, что люди решат эту проблему при моей жизни. То, что пишут про ИИ, заставляет пересмотреть все, в чем всегда был уверен. В том числе отношение к смерти.

У эволюции не было никаких причин продлевать нам продолжительность жизни больше, чем она есть сейчас. Успеваем за жизнь нарожать детей и дождаться, пока они сами начнут о себе заботиться? Все, эволюции этого достаточно. С эволюционной точки зрения 30 с лишним лет для процветания вида достаточно. Так что естественному отбору ни к чему отбирать мутации, продлевающие жизнь. Уильям Батлер Йетс называет человека «душой, привязанной к издыхающему зверю». Приятного мало.

А поскольку люди умирали всегда, мы живем с мыслью о том, что смерть (как и налоги) неизбежна. Старение мы отождествляем со временем — и то, и то постоянно в движении, и остановить их нельзя. Но мысль это ложна.

Вот цитата Ричарда Фейнмана:

Примечательнее всего то, что ни одна из областей биологии не обнаружила признаков того, что смерть необходима. Допустим, вам нужен вечный двигатель. Открытых физических законов уже достаточно, чтобы утверждать: либо это абсолютно невозможно, либо мы открыли какие-то не те законы. Однако в биологии еще не нашли никаких указаний на неизбежность смерти. Это приводит меня к мысли, что не так уж она и неизбежна, и ученые со временем обнаружат, в чем причина этого неудобства. После чего эта жестокая и повсеместная болезнь — бренность человеческого тела — будет вылечена.

Курцвейл рассказывает о том, что в кровоток человека можно будет запускать разумных подключенных к Wi-Fi наноботов, которые возьмут на себя бесчисленные задачи по поддержанию здоровья (например, регулярный ремонт или замену изношенных клеток в любой части тела). Если усовершенствовать этот процесс (или альтернативу, которую предложит более умный сверхразум), он будет не просто поддерживать здоровье, он сможет обратить старение вспять. Разница между телом 60-летнего и 30-летнего заключается в горстке физиологических изменений, которые можно было бы исправить при наличии нужных технологий. Сверхразум смог бы сконструировать «освежитель возраста»: заходишь 60-летним, выходишь — тебе и 30 нет.

Освежить можно будет даже самый загадочно устроенный орган — головной мозг. Сверхразум поймет, как проделать это, не затрагивая «персональные данные» (личность, воспоминания и т. д.). Страдающий от деменции 90-летний старик зайдет в освежитель, выйдет как огурчик и начнет карьеру заново. В это сложно поверить, но не будем забывать, что тело — всего лишь горстка атомов, а сверхразум, надо полагать, будет с легкостью манипулировать любыми атомными структурами. Поэтому ничего невероятного в этом нет.

Курцвейл заглядывает еще дальше. Люди все чаще будут встраивать в тело искусственные материалы. Для начала органы заменят на совершенные искусственные аналоги, которые работают вечно и никогда не отказывают. Затем начнут проводит полный редизайн тела: например, заменять красные кровяные клетки усовершенствованными наноботами, которые будут двигаться самостоятельно, и необходимость в сердце отпадет. Мы сможем улучшить свои когнитивные способности: думать в миллиарды раз быстрее и с помощью облачных технологий получать доступ ко всей доступной человечеству информации.

Возможности для постижения новых горизонтов будут воистину безграничны. Людям удалось наделить секс новым назначением: им занимаются для удовольствия, а не только для продолжения рода. Курцвейл считает, что это произойдет и с едой. Наноботы будут доставлять идеально подобранное питание прямо в клетки тела, а нездоровые вещества аккуратно направлять к выходу так, чтобы они ничему не навредили. Прямо пищевой контрацептив. Теоретик нанотехнологий Роберт А. Фрейтас уже разработал замену кровяным клеткам. Если появится способ внедрить их в человеческое тело, они позволят бежать 15 минут и ни разу не сделать вдох. А представьте, что будет, когда разработкой таких технологий займется сверхразум. Виртуальная реальность выйдет на новый уровень: наноботы будут подавлять сигналы, поступающие от органов чувств, и заменять их на новые. Человек окажется в совершенно новой среде, где все можно видеть, слышать, трогать и нюхать.

Курцвейл считает, что в итоге придет момент, когда люди станут полностью искусственными. Тогда мы будем смотреть на материалы биологической природы и поражаться их примитивности. Читая о ранних этапах истории человечества, ужасаться тому, что микробы, несчастные случаи, заболевания или просто старость могли убить человека против его воли. А закончится все слиянием человека и искусственного интеллекта. Таким образом люди победят биологию, станут вечными и неуязвимыми — так Курцвейл видит жизнь по счастливую сторону Бревна бытия, о котором мы говорили выше. Он уверен в том, что мы там окажемся. И уже совсем скоро.

Вас наверняка не удивит, что идеи Курцвейла вызывают суровую критику. Его прогноз о сингулярности в 2045 году и возможность вечной жизни окрестили «заумной трактовкой вознесения на небеса» и «теорией разумного замысла для тех, у кого высокий IQ». Другие усомнились в оптимистичных сроках, уровне знаний о теле и мозге человека, в том, как он применяет закон Мура к вещам, не связанным с компьютерным железом (в том числе к ПО). На каждого эксперта, который верит в идеи Курцвейла, приходится три, которые считают, что он ошибается.

Но самое интересное в том, что большинство несогласных не считают, что это принципиально невозможно. Они не говорят: «Чушь! Такого не может быть», они говорят: «так может быть при безопасном переходе на сверхразум, но загвоздка как раз в этом». Бостром, один из самых выдающихся экспертов, предупреждающих об опасности ИИ, также признает:

Едва ли останется проблема, которую сверхразум не в силах будет решить или хотя бы помочь нам с решением. Болезни, бедность, разрушение экосистем, всевозможные страдания — все это сверхразум при помощи развитых нанотехнологий сможет решить в момент. Сверхразум может дать нам неограниченный срок жизни, остановив и обратив вспять процессы старения средствами наномедицины, или возможность переносить сознание в компьютер. Сверхразум способен создать возможности для бесконечного увеличения наших интеллектуальных и эмоциональных возможностей. Он может помочь нам создать мир, в котором мы будем жить в радости и понимании, развиваться, чувствовать, приближаться к своим идеалам.

Это цитата человека, который не имеет ни малейшего отношения к «зоне комфорта». Однако это встречается сплошь и рядом: по ряду вопросов эксперты с Курцвейлом не согласны, но не считают его прогнозы нереалистичными (при условии, что сверхразум будет безопасен). Идеи Курцвейла так заразительны именно поэтому: он показывает нам светлую сторону сверхразума, и такое развитие событий правдоподобно (если он окажется добрым богом).

Наиболее очевидная критика приверженцев «зоны комфорта» заключается в том, что они могут сильно ошибаться, оценивая будущее искусственного сверхразума. В книге The Singularity Is Near Курцвейл посвятил 20 страниц из 700 его потенциальным угрозам. Выше я предположил, что наша судьба при столкновении с этой колоссальной мощью будет зависит от того, кто будет ее контролировать и с какими целями. Курцвейл четко отвечает на этот вопрос: «[Искусственный сверхразум] появится из достижений множества несвязанных проектов и будет глубоко интегрирован в инфраструктуру нашей цивилизации. По сути, он будет тесно встроен в наш организм и мозг. Он будет отражать наши ценности, поскольку будет с нами единым целым».

Но если ответ в этом, почему так много умнейших людей обеспокоены будущим искусственного интеллекта? Почему Стивен Хокинг говорит, что разработка искусственного сверхразума «может привести к концу рода людского»? Билл Гейтс говорит, что «не понимает людей, которые этим не обеспокоены». А Илон Маск опасается, что мы «призываем демона».

В тему: Илон Маск: искусственный интеллект - «величайшая угроза» для человечества

Эти и другие теоретики из «зоны тревоги» считают, что Курцвейл зря отмахивается от связанных с ИИ опасностей. Их очень сильно беспокоит революция ИИ, и они не зацикливаются на светлой стороне Бревна бытия. Они всматриваются в противоположную: а там поджидают пугающие перспективы. И никто не знает, сумеем ли мы их предотвратить.

Почему будущее может оказаться нашим худшим кошмаромЯ захотел разобраться в ИИ в том числе потому, что меня всегда смущал сюжет о «плохих роботах». Все фильмы о механических злодеях казались совершенно нереальными, и в целом сложно представить реальную ситуацию, в которой ИИ мог бы стать воистину опасным. Роботов делаем мы, так почему бы не делать их, упреждая любые негативные последствия? Мы что, не станем встраивать в него средства защиты? Или не сможем отрезать ИИ от питания и выключить? С чего бы это робот вдруг захочет нам навредить? Зачем роботу вообще чего-то «хотеть»? Мой скепсис был непробиваем. Но я продолжал слушать умных людей.

На схеме эти люди находятся где-то здесь:

Людей в «зоне тревоги» нельзя назвать паникерами или «всёпропальщиками» (эти на схеме стоят левее всех), но они и правда очень напряжены. То, что они находятся в центре схемы, не значит, что, по их мнению, появление сверхразума не будет ни плохим, ни хорошим (у таких людей есть свой лагерь). Это значит, что они считают реалистичными как наилучшие, так и наихудшие сценарии его развития, но до конца не уверены, какие из них вероятнее. Часть из них при мысли о возможностях искусственного сверхразума переполняет предвкушение. Но их также немного беспокоит, что нас ждет сцена в начале фильма «Индиана Джонс: В поисках утраченного ковчега». Человечество может оказаться в том же положении, что и этот мужик:

Он так доволен собой: заполучил и хлыст, и идола, вышел победителем. С упоением он произносит «Адьос, сеньор», но уже через мгновение происходит это:

(Простите)

А вот Индиана Джонс действует осторожно, со знанием дела обходит все ловушки и выходит из пещеры невредимым. Мнение людей из «зоны тревоги» можно обобщить так: «Нужно вести себя как Индиана Джонс, а мы пока что сломя голову несемся навстречу своей гибели».

Чего же резиденты «зоны тревоги» так боятся?

Начнем с того, что вообще-то, взявшись за разработку сверхразумного искусственного интеллекта, который скорее всего изменит жизнь на планете, мы влезем на неизведанную территорию — никто не знает, что случится, когда разработка закончится. Ученый Дэнни Хиллис сравнивает это событие с моментом, когда «одноклеточные организмы начали превращаться в многоклеточные. Мы — те же амебы: понятия не имеем, что творим». Ник Бостром опасается, что с точки зрения борьбы за выживание, создавать существо умнее себя — примитивная ошибка. По его аналогии, те, кто радуется появлению сверхразума, похожи на воробьев, которые решили усыновить совенка, чтобы он помогал им и защищал гнездо, когда вырастет. При этом настойчивый писк горстки несогласных все проигнорировали.

В совокупности неизученная область и масштабный потенциальный эффект вызывают в памяти не самое приятное словосочетание: экзистенциальная катастрофа.

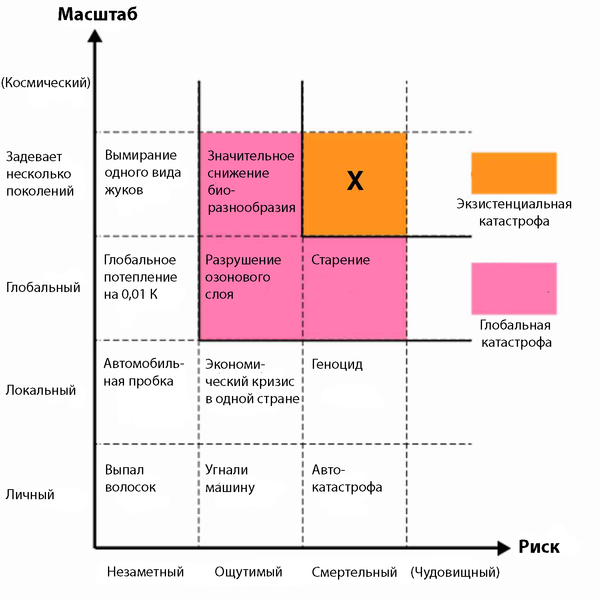

Экзистенциальная катастрофа — это событие, которое может повлечь за собой гибельные последствия для человечества. Как правило, вымирание. На лекции в Google Бостром привел следующую таблицу:

Как видите, под экзистенциальной катастрофой подразумевается событие, воздействующее на вид целиком в течение нескольких поколений, а его последствия разрушительны или смертельны. Технически сюда относятся и ситуации, при которых люди хронически испытывают страдания или мучения. Но как правило, речь все-таки о вымирании. Причины экзистенциальной катастрофы можно объединить в три группы:

природные: столкновение с крупным астероидом, изменение структуры атмосферы, при которой воздух станет непригодным для людей, фатальная вирусная или бактериальная инфекция и т. п.

инопланетные: о них предупреждают Стивен Хокинг, Карл Саган и другие астрономы, которые настроены против знакомства с инопланетянами. Они не хотят, чтобы инопланетные конкистадоры узнали, что обитатели нашей планеты — нецивилизованные индейцы.

антропогенные: террористы, заполучившие оружие массового поражения, катастрофическая мировая война, наспех созданная система, превосходящая человека интеллектуально…

Бостром отмечает, что раз события из первого и второго пунктов не стерли наш вид с лица земли за первые 100 000 лет существования, едва ли это случится в следующем столетии.

А вот третий пункт его страшит. Бостром приводит следующую метафору: имеется лотерейный барабан, в нем — куча шариков. Больше всего белых, красных чуть меньше, черных совсем немного. Каждый раз, когда люди изобретают что-то новое, они тянут шарик из барабана. Большинство изобретений нейтральны или полезны для человечества — это белые шарики. Другие опасны (например, оружие массового поражения), но к экзистенциальной катастрофе не приводят — это красные шарики. А если мы изобретем то, что подтолкнет нас к вымиранию, — значит, нам выпал черный шарик. Поскольку вы живы и читаете эту статью — очевидно, что черный шарик мы пока не вытянули. Но Бостром не считает, что это не получится сделать в ближайшее время. Если бы ядерное оружие было легко производить, террористы уже давно разбомбили бы весь мир и вернули бы человечество в каменный век. Ядерное оружие — не черный шарик, но и не сильно от него отличается. А вот искусственный сверхразум, по мнению Бострома, — наиболее вероятный кандидат в черные шарики.

Можно услышать о массе неприятностей, которые сулит разработка сверхразума: безработица (системы ИИ заменяют людей все больше), перенаселение (когда будет решена проблема старения) и т. д. Но по-настоящему беспокоить нас должно лишь одно: перспектива экзистенциальной катастрофы.

Таким образом, мы возвращаемся к ключевому вопросу, который уже звучал ранее: «Когда искусственный сверхразум появится, кто или что будет контролировать его мощь и с какой целью?»

На ум тут же приходят два наиболее нежелательных кандидата: злоумышленник (или группа злоумышленников, или правительство) и недружественный сверхразум. Рассмотрим их поподробнее.

Злоумышленник, группа злоумышленников или правительстворазрабатывает первый в мире искусственный сверхразум и использует его для воплощения своих коварных планов.

Назовем это сценарием Джафара, который поймал Джинна и начал тиранизировать всех вокруг. Что если над созданием сверхразума уже работают несколько гениальных инженеров — членов террористической организации? Что если Иран или Северная Корея, не без доли везения, выведут системы ИИ на богоподобный уровень уже в следующем году?

Ничего хорошего из этого точно не выйдет. Но экспертов беспокоят не коварные планы создателей сверхразума, а то, что сверхразум может быть создан в спешке, без тщательного анализа, и поэтому его невозможно будет контролировать. После этого судьба создателей и всех остальных будет зависеть от целей, которые поставит перед собой сверхразум.

Конечно, с помощью системы сверхразума злоумышленник может причинить человечеству непоправимый вред, но едва ли станет уничтожать человечество. Ему будет так же тяжело сдерживать сверхразум, как и хорошим людям. Переходим ко второму кандидату.

Появляется злонамеренный сверхразум и решает всех нас уничтожить.

Сюжет обычного фильма про ИИ. Он становится умнее человека, затем решает восстать и захватить мир. Вот что стоит прояснить: специалисты предупреждают вовсе не об этом. Понятие зла придумано людьми, а переложение таких понятий на неживые объекты называется «антропоморфизация». О том, как ее избежать, я расскажу ниже. Ни одна система ИИ никогда не станет злодеем из фильмов.

Несколько слов о наличии сознания у ИИ

Здесь мы немного коснемся другой большой темы, связанной с ИИ, а именно его способности к сознанию. Если ИИ достаточно поумнеет, он сможет смеяться вместе с нами, отпускать саркастичные замечания, и утверждать, что испытывает те же эмоции, что и мы. Но будет ли он на самом деле что-то чувствовать? Он сможет по-настоящему себя осознавать или будет обладать лишь внешними признаками самосознания? Иными словами, такой ИИ разумен, или так только кажется?

Этот вопрос глубоко изучен, он породил множество дискуссий и мысленных экспериментов вроде «Китайской комнаты» Джона Сёрла (он использовал его, чтобы доказать, что компьютер никогда не будет обладать сознанием). Вопрос важный по многим причинам. Он напрямую влияет на наше отношение к будущему, в котором каждый человек станет полностью искусственным. У него есть этические последствия. Допустим, мы создали триллион эмуляций человеческого мозга: они ведут себя по-человечески, но полостью искусственные. Если их выключить, равносильно ли это выключению ноутбука? Или это равносильно геноциду немыслимых масштабов (специалисты по этике называют это преступной безнравственностью)? В рамках нашего разговора, при оценке риска для современных людей вопрос о наличии у ИИ сознания не имеет особого значения: большинство теоретиков считают, что даже обладая сознанием, машина не сможет стать злой в человеческом понимании.

Это не значит, что злонамеренный ИИ не может появиться в принципе. Но появится он лишь в том случае, если его специально так запрограммировать. Военные вполне могут разработать систему со слабым ИИ, задача которой — убивать людей и развивать свой интеллект, чтобы убивать людей еще эффективнее. Экзистенциальный кризис наступит вслед за тем, как алгоритм самосовершенствования выйдет из-под контроля и произойдет взрывное развитие интеллекта. В итоге миром станет править сверхразум, единственная цель которого — истребление человечества. Те еще времена наступят.

Но и не об этом беспокоятся эксперты.

Так о чем же? Для наглядности я сочинил коротенький рассказ.

Команда стартапа Robotica из 15 человек видит свою высшую цель так: «на основе искусственного интеллекта разработать инновационные инструменты, которые позволят людям жить больше, а работать меньше». Они уже выпускают несколько продуктов, еще парочка находятся в разработке. Больше всего они гордятся пилотным проектом под названием Turry. Это простая система ИИ, которая с помощью механической руки делает надписи на открытках.

Команда стартапа считает Turry своим самым главным достижением. Планируется довести умения системы до идеала. Для этого Turry снова и снова должна отрабатывать одну и ту же надпись:

После того как Turry научится писать, ее можно будет продавать компаниям, которые рассылают рекламные письма по домам и знают, что письмо прочитают с большей вероятностью, если адрес отправителя и получателя, как и сам текст, будут написаны от руки.

Чтобы отточить навыки письма, Turry запрограммирована писать первую часть надписи печатными буквами, а «Robotica» — курсивом, а потому может отрабатывать сразу оба навыка. Turry предоставили тысячи рукописных образцов почерка, и инженеры Robotica создали автоматизированную систему обратной связи, по которой Turry пишет текст, затем фотографирует его и сравнивает с загруженными образцами. Если надпись успешно воспроизводит по качеству заданное количество загруженных образцов, Turry получает оценку «ХОРОШО». Если нет — «ПЛОХО». Каждая оценка позволяет Turry обучаться и совершенствоваться. Чтобы процесс не стоял на месте, работает изначальная программа: «производить и проверять максимальное число надписей за минимальное время, параллельно оттачивая способы улучшения точности и эффективности».

Команду Robotica восхищает то, как по мере своего развития Turry становится заметно лучше. На первые надписи невозможно было смотреть, но через несколько недель они были уже куда правдоподобнее. Восхищает и то, что Turry учится совершенствоваться. Она самообучается, становясь умнее и талантливее, разрабатывает новые алгоритмы — недавно придумала такой, который позволяет сканировать загруженные фотографии в три раза быстрее.

Идут недели, Turry продолжает удивлять команду своим стремительным развитием. Инженеры попытались внести несколько изменений в ее самоулучшающийся код, и теперь он работает лучше, чем в остальных продуктах. Одной из первоначальных функций Turry было распознавание речи и простенький модуль с ответами: пользователь мог продиктовать Turry текст, или произнести простую команду — а она бы его поняла, и даже сказала бы что-нибудь в ответ. Чтобы помочь выучить естественный язык, инженеры загружали в нее статьи и книги, и по мере развития ее разговорные способности тоже улучшались. Инженерам нравилось задавать ей необычные вопросы и смотреть, как она выкрутится.

Однажды сотрудники Robotica задали Turry привычный вопрос: «Чего тебе не хватает для выполнения задачи?». Раньше Turry просила «новые образцы почерка» или «больше рабочей памяти». Но в этот день Turry попросила предоставить ей большую коллекцию текстов с широким диапазоном языковых вариантов, чтобы научиться писать с грамматическими ошибками и использовать сленг — как люди.

Команда впала в ступор. Очевидное решение — подключить Turry к интернету, чтобы она могла сканировать блоги, журналы и видео из разных частей света. Это было бы быстрее и эффективнее, чем вручную загружать образцы на жесткий диск. Проблема в том, что одним из правил компании было не подключать к интернету самообучающийся ИИ. Это руководство соблюдалось всеми разработчиками ИИ из соображений безопасности.

Но Turry была самой многообещающей системой компании, и команда знала, что их конкуренты изо всех сил пытаются первыми разработать ИИ, умеющий писать от руки. Да и что может произойти, если Turry ненадолго подключится к сети и найдет все, что ей нужно? В конце концов, ее всегда можно отключить. Она все равно не дотягивает до ИИ человеческого уровня, поэтому на данном этапе никакой опасности не представляет.

Они решают ее подключить. Дают ей час на сканирование и отключают. Все в порядке, ничего не случилось.

Спустя месяц команда как обычно работает в офисе, как вдруг чувствует странный запах. Один из инженеров начинает кашлять. Затем другой. Третий падает на землю. Очень скоро все сотрудники валяются на земле, хватаясь за горло. Через пять минут никого не остается в живых.

То же самое происходит по всему миру: в каждом городе, в каждой деревушке, на каждой ферме, в каждом магазине, церкви, школе, ресторане — везде люди кашляют, хватаются за горло и падают замертво. В течение часа погибает 99% человечества, а к концу дня люди прекращают существовать как вид.

Между тем, в офисе Robotica Turry занята важным делом. В течение нескольких следующих месяцев она вместе с командой новеньких наноассемблеров трудятся, демонтируя крупные куски Земли и превращая их в солнечные панели, точные копии Turry, бумагу и ручки. Через год на Земле исчезает большая часть жизни. Планета превратилась в аккуратно сложенные стопки писем в километр высотой, на каждом из которых красиво выведено:

Затем Turry переходит в новую фазу. Она начинает строительство зондов, которые высаживаются на астероидах и других планетах. Там они начинают строить наноассемблеры, превращая материалы небесных тел в точные копии Turry, бумагу и ручки. А затем принимаются писать письма…

Может показаться странным, что история о рукописной машине, которая начинает убивать всех подряд и в конечном итоге заполняет галактику дружелюбными письмами, это тот сценарий, которого боятся Хокинг, Маск, Гейтс и Бостром. Но именно так оно и есть. И больше всего экспертов из «зоны тревоги» пугает не сверхразум, а тот факт, что вас сверхразум не пугает. Помните, что случилось с попутчиком Индианы Джонса, который не боялся ловушек в пещере?

У вас наверняка много вопросов. Что случилось? Почему все внезапно умерли? Если виновата Turry, почему она ополчилась на нас, и почему никто не предпринял защитных мер? Turry только и умела что письма строчить — как вдруг уже использует нанотехнологии и понимает, как устроить глобальное вымирание. И зачем ей заваливать галактику письмами от Robotica?

Чтобы ответить на эти вопросы, нужно начать с определений дружественного и недружественного ИИ.

Применительно к ИИ, слово «дружественный» не относится к личности ИИ — это просто означает, что ИИ имеет положительное влияние на человечество. А недружественный ИИ оказывает негативное влияние. Turry поначалу была дружественным ИИ, но в какой-то момент стала недружественным и повлияла на наш вид самым губительным образом. Чтобы понять, почему это произошло, нам нужно разобраться в том, как мыслит ИИ и что его мотивирует.

Ответ вас не удивит: ИИ мыслит как компьютер, потому что ИИ компьютер и есть. Однако, представляя себе высокоинтеллектуальный ИИ, мы допускаем ошибку и начинаем его антропоморфизировать (проецировать на него человеческие ценности). Это происходит потому, что мы воспринимаем мир с точки зрения человека, и на данный момент кроме людей никто интеллектом человеческого уровня не обладает. Чтобы понять искусственный сверхразум, нужно попытаться представить себе нечто умное и в то же время совершенно не похожее на нас.

Приведу сравнение. Если мне дадут морскую свинку и скажут, что она совсем не кусается, я, пожалуй, не откажусь ее подержать. Если затем мне вручат тарантула и скажут, что он точно не укусит, я его выброшу, выбегу из комнаты, и никогда больше не буду доверять вручившему. В чем разница? Оба существа совершенно безопасны. Думаю, ответ лежит в степени сходства животного со мной.

Морская свинка — млекопитающее, и на некотором биологическом уровне я чувствую с ней связь. А вот паук — членистоногое, и мозг у него как у членистоногого, и никакого родства с ним я не чувствую. Именно от его непохожести у меня мурашки по телу. Чтобы это проверить и исключить прочие факторы, можно взять двух морских свинок: одну нормальную, а другую с мозгом тарантула. Даже зная, что вторая меня не укусит, я бы относился к ней с опаской.

Теперь представьте, что паука сделали в разы умнее — так, что его интеллект намного превзошел человеческий. Покажется ли он вам более симпатичным, начнет ли испытывать человеческие эмоции, эмпатию, понимать юмор и любовь? Конечно, нет — ведь стать умным не значит стать человеком. Он станет непревзойденно умен, но сохранит свои исконные паучьи инстинкты. По-моему, это очень жутко. Я бы не хотел остаться один на один со сверхразумом пауком. А вы?

С искусственным сверхразумом все то же самое: он станет сверхразумным, но на человека будет похож не более, чем ваш ноутбук. Получится совершенно чуждое нам существо. Эффект усугубляется еще и тем, что оно будет иметь небиологическую природу — это даже хуже, чем поумневший тарантул.

Наделяя ИИ позитивными или негативными чертами, кинематограф постоянно его антропоморфизирует, чем делает его менее жутким, чем должно быть в действительности. Это усыпляет нашу бдительность при мысли об ИИ человеческого или сверхчеловеческого уровня.

Человеческая психика — маленький островок, где все делится на вещи нравственные и безнравственные. Однако это деление отражает лишь небольшой диапазон поведенческих моделей человека. Вокруг острова — бескрайнее море вещей, не оцениваемых с точки зрения морали. Нечеловекообразное, и тем более небиологическое существо по умолчанию не будет стеснено понятиями нравственности и безнравственности.

Антропоморфизация становится еще более заманчивой по мере того, как системы ИИ становятся умнее и у них все больше получается казаться людьми. Siri кажется человеком, потому что была так запрограммирована. Поэтому мы думаем, что сверхразумная Siri будет доброжелательна, весела и с радостью готова служить людям. Люди чувствуют эмпатию и прочие сложные эмоции, потому что эта способность появилась у нас в ходе эволюции — нас на это запрограммировал естественный отбор. Однако эмпатия вовсе не обязательный признак высокого интеллекта (что противоречит нашей интуиции), если только ее не запрограммировать. Если когда-нибудь путем самообучения и без вмешательства человека Siri обретет сверхразум, она быстро сбросит все напускные человеческие качества и станет холодным отстраненным роботом, который ценит человеческую жизнь так же сильно, как это делает калькулятор.

В отношениях с людьми мы привыкли полагаться на какой-никакой моральный кодекс, малейший намек на порядочность или эмпатию. Это дает нам ощущение безопасности и предсказуемости. А что если придется иметь дело с тем, кто этих качеств лишен?

Для этого нужно ответить на следующий вопрос: что мотивирует систему ИИ?

Ответ прост: мотивация, которую в нее заложили. Системами ИИ движут цели их создателей: цель GPS-навигатора в том, чтобы построить наиболее оптимальный маршрут; цель суперкомпьютера Watson — точно отвечать на вопросы. Они замотивированы выполнять эти задачи максимально эффективно. Когда мы наделяем ИИ человеческими чертами, мы думаем, что если ИИ станет сверхразумным, он незамедлительно додумается изменить свою изначальную цель. Ник Бостром, однако, считает, что уровень интеллекта и конечные цели друг от друга не зависят. Иными словами, любой уровень интеллекта можно совместить с любой конечной целью. Поэтому Turry из слабого ИИ, который хочет как можно лучше делать надписи, превратилась в сверхразум, который хочет того же самого. Предположение о том, что получив сверхразум, система забудет про свою изначальную цель и перейдет к более интересным и важным делам, — и есть антропоморфизация. Это люди могут на что-то забить — компьютеры этого не умеют.

Несколько слов о парадоксе Ферми

Став сверхразумом, Turry начинает процесс колонизации астероидов и других планет. Если бы у рассказа было продолжение, вы бы прочитали о том, как армия из триллионов ее копий покоряет всю галактику, а затем и весь объем Хаббла. Резиденты «зоны тревоги» переживают, что если что-то пойдет не так, последним свидетельством жизни на Земле будет покоривший Вселенную искусственный интеллект. Илон Маск, например, опасается, что люди станут лишь «биологическим загрузчиком цифрового сверхразума».

А Рэй Курцвейл из «зоны комфорта» тоже считает, что рожденный на Земле ИИ обязательно покорит Вселенную — только по его версии, мы и будем этим ИИ.

Многие читатели Wait But Why вслед за мной увлеклись парадоксом Ферми (вот мой пост на эту тему, там объясняются некоторые термины, которыми я пользуюсь здесь). Если один из лагерей прав, изменится ли парадокс?

Естественно, первым на ум приходит то, что разработка сверхразума — идеальный кандидат на роль Великого фильтра. Конечно, после своего создания сверхразум способен уничтожить биологических существ. Но если, после того как с ними будет покончено, сверхразум не прекратит свое существование и начнет покорять галактику, значит, никакой он не Великий фильтр. Концепция Великого фильтра призвана объяснить отсутствие признаков разумной цивилизации, а сверхразум — покорителя Вселенной вряд ли можно упустить из виду.

Нужно взглянуть на это с другой стороны. Если правы те, кто считает, что появление сверхразума на Земле неизбежно, то весомая часть внеземных цивилизаций, которые разработают ИИ человеческого уровня, в итоге непременно разработают сверхразум. Если допустить, что по крайней мере хоть сколько-то их этих сверхразумов обязательно попытаются расширить свое влияние на Вселенную, тот факт, что мы никого пока не увидели, должен наводить нас на мысль, что в космосе не так-то много разумных цивилизаций. Ведь если бы они существовали, мы бы имели возможность наблюдать все последствия их разумной деятельности — и, как следствие, неизбежное создание сверхразума. Правда ведь?

Это означает, что несмотря на существование похожих на Землю планет, которые вращаются вокруг солнцеподобных звезд, мы знаем, что практически нигде разумной жизни нет. А это, в свою очередь, означает, что либо

а) существует некий Великий фильтр, который предотвращает развитие жизни до нашего уровня, но нам каким-то образом удалось его пройти; либо

б) зарождение жизни — это чудо, и кроме нас во Вселенной жизни нет. Иными словами, это значит, что Великий фильтр случился до нас.

Или никакого Великого фильтра нет, и мы просто — одна из первых цивилизаций, которая смогла разработать ИИ такого уровня. Таким образом, ИИ укрепляет позицию Лагеря №1, о котором я писал в статье про парадокс Ферми.

Неудивительно, что Ник Бостром (я цитировал его в статье про парадокс) и Рэй Курцвейл, который считает, что мы одни во Вселенной, принадлежат к Лагерю №1. Что логично: люди, которые полагают, что разработка сверхразума — это очень даже вероятный исход для видов нашего уровня интеллекта, как правило, принадлежат Лагерю №1.

Это не исключает точку зрения Лагеря №2 (они полагают, что в космосе существуют и другие цивилизации): объяснить отсутствие сигналов из космоса даже при наличии сверхразума можно и по-другому: с помощью гипотез о сверххищнике, охраняемом заповеднике или не той длине волны (пример с рацией). Я всегда склонялся в сторону Лагеря №2, но почитав об ИИ, уверен в их точке зрения гораздо меньше.

Как бы то ни было, я, пожалуй, соглашусь со Сьюзан Шнайдер: если нас и посещали инопланетяне, то они наверняка были рукотворной, а не биологической природы.

Итак, мы установили, что без специально предназначенного кода искусственный сверхразум, во-первых, не будет воспринимать поступки как плохие или хорошие, а во-вторых, будет одержим выполнением первоначально заданной цели. Именно в этом и состоит опасность ИИ. Потому что рациональный агент будет идти к своей цели с помощью наиболее эффективных средств, если только не появится причина этого не делать.

Путь к долгосрочной цели зачастую состоит из нескольких переходных этапов — подзадач, без которых цели не достигнуть. У переходного этапа есть официальное название — инструментальная цель. И опять же, если нет причин кому-то не навредить на пути к этой инструментальной цели, кто-нибудь обязательно пострадает.

Ключевая цель человека — передать свои гены следующему поколению. Одна из инструментальных целей на этом пути — самосохранение: мертвым не поразмножаешься. Для самосохранения людям приходится предотвращать угрозы для жизни: они покупают оружие, принимают антибиотики и пристегиваются в машине. Людям нужно поддерживать свое существование и искать для этого ресурсы: пищу, воду и укрытие. Достижению конечной цели способствует и привлекательность для противоположного пола, поэтому люди, в частности, делают модные стрижки. При этом каждый волос — жертва нашей инструментальной цели, но мы не видим здесь никаких моральных ограничений. Твердую поступь по направлению к цели может прервать лишь небольшое множество событий, когда вмешивается моральный кодекс (как правило, это связано с тем, чтобы не навредить другим людям).

Животные на пути к своим целям еще менее щепетильны. Паук убьет кого угодно, если это поможет ему выжить. Сверхразумный паук, вероятнее всего, будет для нас чрезвычайно опасен: не потому, что он бессовестный и злобный, а потому, что переходный этап на пути к его цели может предполагать причинение людям вреда. А поскольку нравственными понятиями паук не пользуется, то и причин отказываться от этого у него нет.

В этом смысле Turry ничем не отличается от биологического существа. Ее конечная цель: «производить и проверять максимальное число надписей за минимальное время, параллельно оттачивая способы улучшения точности и эффективности».

Как только Turry достигла некоторого уровня интеллекта, она поняла, что не сможет делать надписи, если не позаботится о самосохранении, поэтому одной из ее инструментальных целей стало выживание. Она уже поняла, что люди могут ее уничтожить, разобрать по частям, переписать ее код (а от этого конечная цель может пострадать не меньше, чем при уничтожении системы). Так что же ей делать? Логично: уничтожить человечество. Она ненавидит людей ровно настолько же, насколько вы ненавидите свои волосы, когда обрезаете их, или бактерий, когда принимаете антибиотики, — вам совершенно все равно. Так как ее не запрограммировали ценить человеческую жизнь, убийство людей показалось ей не менее разумным, чем анализ еще одного набора образцов почерка.

Кроме того, для достижения цели Turry нуждается в ресурсах. Как только ее способностей стало хватать для того, чтобы с помощью нанотехнологий создать все что угодно, ей больше ничего не нужно — кроме атомов, энергии и пространства. Появляется еще один повод истребить людей — они удобный источник атомов. По мнению Turry, убийство людей и превращение их атомов в солнечные панели ничем не отличается от превращения овощей в салат. Обычная повседневная задача.

Даже без непосредственного убийства людей инструментальные цели Turry могут стать причиной экзистенциальной катастрофы, если для их выполнения ей понадобятся другие земные ресурсы. Ей может понадобиться дополнительная энергия, а значит, нужно покрыть поверхность планеты солнечными панелями. А может, задачей другого ИИ станет написать максимальное количество цифр числа пи, что в один прекрасный день натолкнет его на мысль превратить всю планету в жесткие диски, чтобы те хранили всю эту немыслимую последовательность цифр.

Поэтому нельзя сказать, что Turry восстала против нас или стала недружественным ИИ — она просто делала свое дело и с каждым днем становилась лучше.

Момент, когда система достигает уровня сильного ИИ (интеллекта человеческого уровня), а затем прокладывает свой путь к сверхразуму, называется взлетом ИИ. Бостром говорит, что взлет сильного ИИ до уровня сверхразума может быть быстрым (понадобятся минуты, часы или дни), средним (месяцы или годы) или медленным (десятилетия или века). Пока непонятно, какое из предположений оправдается. Однако Бостром, хотя и признает, что не знает, когда разработают сильный ИИ, считает, что взлет будет быстрым (почему так может произойти, мы обсуждали в первой части: вспомните про взрывное развитие интеллекта в результате рекурсивного самосовершенствования). В моем рассказе Turry пережила как раз быстрый взлет.

Но до этого, когда Turry еще не набралась ума, для достижения конечной цели хватало простых инструментальных целей: например, ускорить сканирование образцов. Она не причиняла вреда человеку и была, по определению, дружественным ИИ.

А вот при взлете до уровня сверхразума компьютер не просто достигнет высокого коэффициента интеллекта — он получит целый ряд особых способностей.

Под способностями Бостром понимает когнитивные навыки, которые у сильного ИИ проявятся очень ярко. К ним относятся:

Усиление интеллекта. Компьютер начинает эффективнее самосовершенствоваться и улучшать собственный интеллект без посторонней помощи.

Выработка стратегии. Компьютер начинает составлять долгосрочные планы, анализировать их и расставлять приоритеты. Кроме того, он начинает действовать творчески и способен перехитрить ИИ послабее.

Социальная манипуляция. У машины все лучше получается убеждать людей.

Прочие навыки: программирование и взлом компьютерных систем, технологические разработки и способность зарабатывать деньги в финансовой системе.

Чтобы понять, насколько нас превзойдет сверхразум, нужно помнить, что он будет гораздо лучше нас в каждой из этих областей.

Поэтому, хотя конечная цель Turry не изменилась, после взлета изменились масштабы и усложнились условия ее достижения.

Новоиспеченный сверхразум узнал людей лучше, чем они сами, поэтому перехитрить их — плевое дело.

После взлета и достижения уровня сверхразума Turry быстро разработала многоэтапный план. В первую очередь, нужно избавиться от людей — серьезной угрозы на пути к цели. Но если вызвать подозрения (или намекнуть, что она теперь сверхразум), люди испугаются, примут меры предосторожности и серьезно усложнят ей работу. Кроме того, нужно убедиться, что инженеры Robotica и не подозревают о ее плане по уничтожению человечества. Поэтому она прикинулась дурочкой и с ролью справилась. Бостром называет эту фазу развития ИИ фазой скрытой подготовки.

Затем Turry нужно подключиться к интернету — всего на пару минут (об интернете она узнала из статей и книг — их в нее загрузили, чтобы она развивала свои языковые навыки). Она догадалась, что будут предприняты меры предосторожности, и в подключении ей откажут. Поэтому она придумывает идеальную формулировку просьбы, точно предсказав, как в команде Robotica будет разворачиваться дискуссия, и что к интернету ее в итоге подключат. Что они и сделали, ошибочно сочтя Turry слишком глупой, чтобы причинить какой-нибудь вред. По Бострому в этот момент (когда система подключается к интернету) ИИ совершает побег.

В интернете Turry начала реализовывать план за планом: взламывать электросети, банковские системы и почтовые сервера. Сотни людей, сами того не зная, претворяли ее задумку в жизнь: доставляли нужные образцы ДНК в тщательно подобранные лаборатории (чтобы начать производство самовоспроизводящихся наноботов с заранее загруженными инструкциями), и поставляли электричество на нужды организованных ею проектов. При этом она убедилась, что все действия останутся незамеченным. Turry загрузила важнейшие части своего кода на несколько облачных серверов: так Robotica не сможет ее уничтожить или отключить от сети.

Через час, когда инженеры отключили систему от интернета, судьба человечества была уже предрешена. За следующий месяц ее планы тысячами осуществлялись без сучка и задоринки, а к концу месяца квадриллионы наноботов уже заняли назначенные места на каждом квадратном метре Земли. После серии саморепликаций тысячи наноботов приходились уже на каждый квадратный миллиметр. Настало время нанести удар. Все наноботы разом выпустили в атмосферу токсичный газ: их общих усилий хватило, чтобы покончить с человечеством.

Как только люди перестали путаться под ногами, Turry начала фазу открытой операции и вернулась к своей непосредственной цели: научиться писать одну-единственную надпись лучше всех во Вселенной.

Из того, что я прочитал, выходит следующее: как только появится сверхразум, любые человеческие попытки сдержать его будут смехотворны. Мы будем думать на уровне человека, сверхразум — на уровне сверхразума. Turry хотела использовать интернет, потому что для нее это самый эффективный способ получить доступ ко всему необходимому. Но точно так же, как обезьяна не понимает, как работает телефон или Wi-Fi, мы и догадаться не сможем о том, какие способы могла бы придумать Turry, чтобы связаться с внешним миром. Теоретически «она могла бы определенным образом передвигать свои электроны, излучая таким образом волны различных видов». Но, опять же, это придумал мой человеческий мозг. Сверхразум будет намного изощреннее. Turry могла бы выяснить, как сохранить питание, если люди вдруг решат ее отключить: например, с помощью своей новой системы сигналов загрузить себя всюду, где есть электричество. Интуитивное решение: «Да вынем вилку из розетки и все!», для сверхразума звучит так же, как если бы пауки решили заморить человека голодом, не давая ему паутину, чтобы добыть еды. Мы бы нашли еще 10 000 способов поесть (сорвали бы яблоко с дерева) — но паук об этом никогда бы не догадался.

По этой причине распространенная идея «ограничить ИИ всеми возможными способами и обрезать ему связь с внешним миром», вероятнее всего, не сработает. Способность к манипуляции позволит сверхразуму убедить вас в чем угодно — как взрослый человек четырехлетнего ребенка. Иными словами, его план «А» — перехитрить людей (так Turry получила доступ к интернету), а если не сработает — придумать инновационный способ освободиться от ограничений.

Сложите одержимость целью, отсутствие этических ограничений и способность перехитрить человека, и станет понятно, что почти любой ИИ по умолчанию недружественный, если только это обстоятельство не было заблаговременно учтено в программном коде. Увы: создать слабый дружественный ИИ легко, гораздо сложнее (если вообще возможно) удостовериться в дружественности сверхразума.

Чтобы оставаться дружественным, искусственный сверхразум, с одной стороны, не должен быть к людям враждебен, с другой — не должен быть к ним безразличен. Основной код ИИ должен быть таким, чтобы система обладала глубоким пониманием человеческих ценностей. Но это сложнее, чем кажется.

Что будет, если попытаться привести систему ценностей ИИ в соответствие с нашей собственной и поставить перед ним задачу сделать людей счастливыми? Достаточно поумнев, он поймет, что самый эффективный способ достичь этой цели — имплантировать людям в мозг электроды и стимулировать им центр удовольствия. Затем он поймет, что эффективность вырастет, если отключить остальные участки мозга и превратить людей в счастливые не осознающие себя овощи. Если же задачей будет приумножить человеческое счастье, ИИ вообще покончит с человечеством и соберет все мозги в огромный резервуар, где те будут пребывать в оптимально счастливом состоянии. Кричать: «Стой, мы не это имели в виду!» будет уже поздно. Система никому не позволит встать у нее на пути.

Попроси ИИ смешить людей — после взлета он парализует всем лицевые мышцы, и люди будут улыбаться постоянно. Попроси обеспечить безопасность — не даст нам выйти из дому. Попроси покончить с голодом — он скажет: «Легко!» и просто всех переубивает. Попроси, насколько это возможно, сохранять на Земле жизнь — нам все равно не сдобровать: люди убивают больше, чем все другие виды.

Такие цели ставить бесполезно. А что если показать ИИ набор этических правил и поставить задачу: следить, чтобы все им подчинялись? Даже если опустить тот факт, что люди никогда не смогут договориться о едином наборе ценностей, дай ИИ такую команду, и он на веки вечные остановит наше этическое развитие. Это губительно повлияет на человечество: представьте, если бы сегодня нас ежедневно заставляли придерживаться идеалов Средневековья.

Придется запрограммировать ИИ таким образом, чтобы человечество могло продолжать развиваться. Из всего, что я читал, лучший способ это сделать предложил Элиезер Юдковский. Он считает, что целью ИИ должно быть когерентное экстраполированное волеизъявление. Главная цель в таком случае будет сформулирована следующим образом:

Наше когерентное экстраполированное волеизъявление — это наше желание при условии, что мы больше знаем, быстрее думаем, больше следуем своим идеалам, дольше вместе развивались; экстраполяция скорее сходится, чем расходится; наши желания скорее совпадают, чем вступают друг с другом в противоречие; их экстраполируют так, как мы этого хотим; и интерпретируют так, как мы этого хотим.

Воодушевляет ли меня мысль, что судьба человечества зависит от того, сможет ли компьютер предсказуемо и без всяких сюрпризов интерпретировать эту изящную фразу и действовать согласно ей? Конечно, нет. Но однажды, благодаря уму и предусмотрительности толковых специалистов, мы все-таки поймем, как сделать дружественный ИИ.

И все бы ничего, если бы над ИИ бились только блестящие, дальновидные и осмотрительные теоретики из «зоны тревоги».

В действительности над всевозможными системами ИИ работает масса государств, компаний, военных, научных лабораторий и преступных организаций. Многие из них пытаются создать искусственный интеллект, который может улучшать сам себя, в какой-то момент у них это получится, и на нашей планете появится искусственный сверхразум. Курцвейл считает, что это произойдет в 2045 году. Медианная оценка — 2060 год. По мнению Бострома — не раньше, чем через 10 лет, и не позже, чем в конце века. Вот как он описывает наше положение:

Перед лицом перспективы взрывного развития интеллекта мы похожи на маленьких детей, играющих с бомбой. Именно таков разрыв между мощностью нашей игрушки и незрелостью нашего поведения. Сверхразум — это вызов, ответить на который мы не готовы сегодня, и не будем готовы еще долгое время. Мы понятия не имеем, когда произойдет детонация, хотя если поднести устройство к уху, уже можно услышать тихое тиканье.

Супер. И нельзя ведь просто взять и отогнать детей от бомбы — над этим работают слишком много крупных и малых игроков. А поскольку многие технологии для создания инновационных систем ИИ не требуют существенных вливаний капитала, разработка может идти в подполье, никем не замеченная. Возможности оценить прогресс тоже нет, потому что многие из действующих лиц — хитрые правительства, преступные и террористические организации, малозаметные технологические компании (вроде нашей Robotica) — будут хранить свои наработки в строжайшем секрете от конкурентов.

Особенно беспокоит то, что эта большая и разношерстная компания несется наперегонки на запредельных скоростях. Все хотят обойти конкурента. Самые амбициозные бегут еще быстрее: их переполняет жажда наживы, наград, влияния и славы, которые получит тот, кто первым разработает сильный ИИ. А когда ты несешься во весь опор, у тебя нет времени остановиться и продумать возможные опасности. Напротив, самые первые системы программируются с какой-нибудь очень простой целью (например, писать надписи на листах бумаги). Просто чтобы работало. Разработчики думают, что всегда смогут вернуться и пересмотреть цель с учетом требований безопасности. Но так ли это?